Доброго дня, читатели блога SEO-Дилетанта. Я всегда получаю много вопросов от вебмастеров, владельцев сайтов и блогеров об ошибках и сообщениях, которые появляются в Яндекс.Вебмастер. Многих такие сообщения пугают.

Но, хочу сказать, не все сообщения бывают критичны для сайта. И в ближайших статьях я постараюсь максимально полно охватить все возможные вопросы, которые могут возникать у вебмастеров. В данной статье пойдет речь о разделах:

- Диагностика — Диагностика сайта

- Индексирование — Страницы в поиске

О том, что такое Яндекс.Вебмастр и зачем он нужен, я писала ещё несколько назад. Если вы не знакомы с данным инструментом, ознакомьтесь сначала со статьей по ссылке.

Диагностика сайта

Возможные проблемы

1. В файле robots.txt не задана директива Host

Данное замечание Яндекс примечательно тем, что директива Host не является стандартизированной директивой, ее поддерживает только поисковая система Яндекс. Нужна она в том случае, если Яндекс неправильно определяет зеркало сайта.

Как правило, зеркало сайта определяется Яндексом автоматически на основе URL, которые формирует сама CMS, и на основе внешних ссылок, которые ведут на сайт. Чтобы указать главное зеркало сайта, не обязательно указывать это в файле robots.txt. Основной способ — использовать 301 редирект, который либо настроен автоматически в CMS, либо необходимый код вносится в файл .htachess.

CMS, с которыми мне приходилось работать в последнее время, WordPress, Joomla, ModX, по умолчанию редиректят адрес с www на без, если в настройках системы указан адрес сайта без приставки. Уверена, все современные CMS обладают такой возможностью. Даже любимый мной Blogger правильно редиректит адрес блога, расположенного на собственном домене.

2. Отсутствуют мета-теги

Проблема не критичная, пугаться ее не нужно, но, если есть возможность, то лучше ее исправить, чем не обращать внимание. Если в вашей CMS по умолчанию не предусмотрено создание мета-тегов, то начните искать плагин, дополнение, расширение или как это называется в вашей CMS, чтобы иметь возможность вручную задавать описание страницы, либо, чтобы описание формировалось автоматически из первых слов статьи.

3. Нет используемых роботом файлов Sitemap

Конечно, лучше эту ошибку исправить. Но обратите внимание, что проблема может возникать и в тех случаях, когда файл sitemap.xml есть, так и в тех, когда его действительно нет. Если файл у вас есть, но Яндекс его не видит, просто перейдите в раздел Индексирование — Файлы Sitemap. И вручную добавьте файл в Яндекс.Вебмастер. Если такого файла у вас вообще нет, то в зависимости от используемой CMS, ищите варианты решения.

4. Не найден файл robots.txt

Все же этот файл должен быть, и если у вас есть возможность его подключить, лучше это сделать. И обратите внимание на пункт с директивой Host.

На этом фонтан ошибок на вкладке Диагностика сайта у меня иссяк.

Вкладку Безопасность и нарушения я пропускаю. К счастью, на нескольких десятках сайтов у меня ни разу не было сообщений в этом разделе. Поделиться нечем.

Индексирование

Страницы в поиске

Начнем именно с этого пункта. Так будет легче структурировать информацию.

Выделяем в фильтре «Все страницы»

![]() Опускаемся ниже, справа на странице «Скачать таблицу» Выбираем XLS и открываем файл в Excel.

Опускаемся ниже, справа на странице «Скачать таблицу» Выбираем XLS и открываем файл в Excel.

Получаем список страниц, которые находятся в поиске, т.е. Яндекс о них знает, ранжирует, показывает пользователям.

Смотрим, сколько записей в таблице. У меня получилось 289 страниц.

А как понять, сколько должно быть? Каждый сайт уникален и только вы можете знать, сколько страниц вы опубликовали. Я покажу на примере своего блога на WordPress.

В блоге на момент написания статьи имеется:

- Записи — 228

- Страницы — 17

- Рубрики — 4

- Метки — 41

- + главная страница сайта

В сумме имеем 290 страниц, которые должны быть в индексе. В сравнении с данными таблицы разница всего в 1 страницу. Смело можно считать это очень хорошим показателем. Но и радоваться рано. Бывает так, что математически все совпадает, а начинаешь анализировать, появляются нестыковки.

Есть два пути, чтобы найти ту одну страницу, которой нет в поиске. Рассмотрим оба.

Способ первый. В той же таблице, которую я скачала, я разделила поиск на несколько этапов. Сначала отобрала страницы Рубрик. У меня всего 4 рубрики. Для оптимизации работы пользуйтесь текстовыми фильтрами в Excel.

Затем Метки, исключила из поиска Страницы, в результате в таблице остались одни статьи. И тут, сколько бы статей не было, придется просмотреть каждую, чтобы найти ту, которой нет в индексе.

Опять же, если на примере WordPress, обратите внимание, какие разделы сайта у вас индексируются, а какие закрыты. Здесь могут быть и страницы Архива по месяцам и годам, страницы Автора, пейджинг страниц. У меня все эти разделы закрыты настройками мета тега robots. У вас может быть иначе, поэтому считайте все, что у вас не запрещено для индексации.

Способ второй. Возвращаемся в Вебмастер, в фильтре выбираем «Исключенные страницы».

![]()

Теперь мы получили список страниц, которые исключены из поиска. Список может быть большой, намного больше, чем со страницами, включенными в поиск. Не нужно бояться, что что-то не так с сайтом.

При написании статьи я пыталась работать в интерфейсе Вебмастера, но не получила желаемого функционала, возможно, это временное явление. Поэтому, как и в предыдущем варианте, буду работать с табличными данными, скачать таблицу можно также внизу страницы.

Опять же, на примере своего блога на WordPress я рассмотрю типичные причины исключения.

В полученной таблице нам в первую очередь важна колонка D — «httpCode». Кто не знает, что такое ответы сервера, прочитайте в википедии. Так вам будет легче понять дальнейший материал.

Начнем с кода 200. Если вы можете попасть на какую-то страницу в интернете без авторизации, то такая страница будет со статусом 200. Все такие страницы могут быть исключены из поиска по следующим причинам:

- Запрещены мета тегом robots

- Запрещены к индексации в файле robots.txt

- Являются неканоническими, установлен мета тег canonical

Вы, как владелец сайта, должны знать, какие страницы какие настройки имеют. Поэтому разобраться в списке исключенных страниц должно быть не сложно.

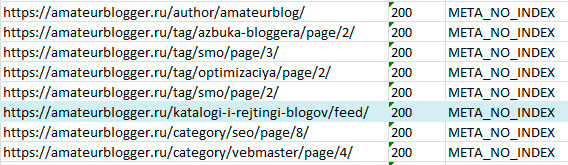

Настраиваем фильтры, выбираем в колонке D — 200

Теперь нас интересует колонка E — «status», сортируем.

Статус BAD_QUALITY — Недостаточно качественная. Самый неприятный из всех статус. Давайте разберем его.

У меня в таблице оказалось всего 8 URL со статусом Недостаточно качественная. Я их пронумеровала в правой колонке.

URL 1, 5, 7 — Страницы фида, 2,3,4,5,8 — служебные страницы в директории сайта wp-json. Все эти страницы не являются HTML документами и в принципе не должны быть в этом списке.

Поэтому внимательно просмотрите свой список страниц и выделите только HTML страницы.

Статус META_NO_INDEX. Из индекса исключены страницы пейджинга, страница автора, из-за настроек мета тега robots

Но есть в этом списке страница, которой не должно быть. Я выделила url голубым цветом.

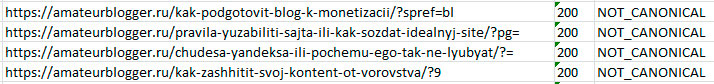

Статус NOT_CANONICAL. Название говорит само за себя. Неканоническая страница. На любую страницу сайта можно установить мета тег canonical, в котором указать канонический URL.

Это очень полезная настройка, когда CMS создает много дублей одной страницы, когда на сайте много страниц пейджинга.

На этом пока заканчиваю. Остальные разделы будут подробно разобраны в следующих постах блога. Подписывайтесь на обновления блога.

Если у вас в Вебмастере есть ошибки из описанных в этой статье разделов, которые я не разобрала, пишите в комментариях, будем разбираться вместе.

Еще такой момент, что вебмастер по отдельности учитывает разные зеркала и лучше кроме главного добавлять и все вариации. В них, например, могут быть видны те внешние ссылки, которые не отображаются на главном зеркале. Быть проиндексированы страницы непроиндексированные на главном зеркале. И т.п.

Спасибо за дополнение, Дмитрий. Согласна, в вебмастер нужно добавлять все зеркала сайта, особенно это актуально для блогов на Blogger на бесплатном домене. Нужно по возможности добавить все доменные зоны.

Не нужно добавлять никаких зеркал вообще! Google этого не рекомендует. К Яндексу то же самое относится. Чем меньше зеркал, тем сильней позиции главного зеркала. Нужно чётко понимать в какой доменной зоне вы продвигаете свой ресурс. Для блогспота в Google — это .com, в Яндексе — .ru. А внешние ссылки могут появиться на другие зеркала, но не в результате работы вебмастера, а посторонних факторов и они, как правило, малозначимы.

Алексей, спасибо за Ваше мнение, Вы верно пишите, про:

1. позиции главного зеркала,

2. понимание, какую зону где продвигать,

3. внешние ссылки,

но Вы не верно поняли о чем идет речь в комментариях выше.

Google Search Console и Яндекс.Вебмастер как инструменты позволяют добавить для отслеживания разные зеркала одного сайта. Это делать просто необходимо, чтобы видеть, что оба поисковика правильно индексируют все зеркала, т.е. одно выделяют главным, а остальные как раз являются зеркалами. В данном случае зеркалами могут быть не только разные доменные зоны блогспота, но и название домена с префиксом или без, также сюда относятся те случаи, когда владельцы сайта покупают несколько доменов в разном написании, в латинице и кириллице. Во всех этих случаях необходимо добавить домен в инструмент для отслеживания индексации. И никто не пишет о том, что должно быть несколько главных зеркал.

Я бы даже не стала рекомендовать одновременно продвигать зоны .ru и .com в Яндексе и Google соответственно. Либо одна зона, либо два разных сайта.

Спасибо за подробный ответ. Как раз сегодня состоялся переезд в Яндекс.Вебмастере моего blogspot с http на https. И сразу появилась рекомендация: Добавьте директиву Host в файл robots.txt. Но, поскольку в blogspot этой возможности нет, немного подожду, пока новое главное зеркало обрастёт статистикой и просто удалю прежнее из Мастера. Тогда, как я понимаю, директива Host просто не потребуется и ошибка будет устранена.

Отличная статья) Спасибо автору, я новичок, мне особенно полезна) Буду постоянным читателем вашего блога)

Про Host нужно дополнить, что эта директива в blogspot не принимается, также, как и редиректы в робот.тхт Яндекс не рекомендует. Ему можно корректно указать на главное зеркало с помощью инструмента Переезд сайта. Если там всё нормально, за несколько дней Главное зеркало будет на месте.

Алексей, спасибо за Ваше дополнение, безусловно, это дельное замечание, но выходит за рамки данной статьи. Статья посвящена разбору инструмента Яндекс.Вебмастер, и я не разбираю в ней настройки каких-либо конкретных CMS или иных платформ.

А зря 😉

Можно было бы расширить статью. И добавить, что Canonical чуть ли не первейшее, что нужно сделать с сайтом на WordPress

Здравствуйте. У меня блог на Blogger. Я добавила в Яндекс.Вебмастер и Google Search Console свой блог в зоне ру. Статьи плохо индексируются, особенно в Гугле. В Гугле робот не видит мои статьи в зоне ру. Оказалось, что все статьи в Гугле индексируются в зоне com. То есть у меня два блога в Гугле. Что с этим делать? Нужно ли добавлять блог в зоне com в Яндекс.Вебмастер и Google Search Console? Если да, то как потом выбрать главный блог? Я там не вижу таких функций.

Татьяна, к сожалению, из-за мультидоменности есть проблемы с индексацией блогов на Blogger. В Google вы должны добавить блог в зоне .com. И только его будет индексировать Google. Что касается Яндекс, то в вебмастер нужно добавить все возможные варианты домена, Яндекс сам склеит так, как посчитает нужным, но как правило, чаще всего яндекс определяет главным зеркалом домен в зоне .ru.

Екатерина, прошу прощения, не видел Ваш коммент, т.к. писали практически одновременно ) Позволю себе высказать свою благодарность блоггер за мультидоменность, а что касается Яндекс.Вебмастер, то при обращении к другим зонам, кроме .ру, у его робота будут постоянные проблемы с редиректами, а, значит, и с индексацией, да и робот.тхт для этих доменов он не увидит.

Редирект — это стандартные рекомендуемые поисковыми системами настройки любого сайта, поэтому «проблем с редиректами» если они не циклические, у сайтов не бывает и быть не может https://yandex.ru/support/search-results/?service=webmaster&query=%D1%80%D0%B5%D0%B4%D0%B8%D1%80%D0%B5%D0%BA%D1%82%D1%8B+%D0%B8+%D0%B7%D0%B5%D1%80%D0%BA%D0%B0%D0%BB%D0%B0

https://support.google.com/webmasters/answer/93633?hl=ru&ref_topic=6001951

Татьяна, поскольку Вы работаете в Blogger, то Ваш блог находится на домене .com и для Гугла он всегда главный. Всегда! Тег «canonical» установлен как .com, независимо от того, в какой зоне открыта страница. Но, когда запрос к блогу поступает из другой зоны, например, из зоны .ru, Blogger редиректит блог на эту зону. Вы не увидите .com в адресной строке своего браузера, поскольку находитесь в зоне .ru. То же самое происходит и с роботом Яндекса. Когда он обращается к blogspot.com, блоггер перенаправляет его в .ру. Таким образом, оставьте в Google Search Console свой blogspot.com, а в Яндексе blogspot.ru, чтобы роботы могли к ним без редиректов обращаться и успешно индексировать. Это самый простой вариант, если Вы не хотите одновременно продвигать все доменные зоны своего блога. Думаю, их очень много.

Алексей, в целом вы все правильно написали, только не до конца понимаете, почему в Яндекс нужно добавить все известные домены (это первое), и второе, Яндексу блог будет показан в зоне .ru тогда и только тогда, когда индексирующий робот будет обращаться к блогу с серверов, располагающихся на территории РФ. Если робот Яндекса обратится к блогу с сервера другой страны (а я не сомневаюсь, что у Яндекса достаточно мощности иметь сервера в других странах мира, в той же Беларуси или Казахстане), то Google его никак не перенаправит на зону .ru, а направит на зону той страны, с которой обращается к блогу индексирующий робот. Соответственно, если в этой стране есть своя доменная зона у Blogger, то покажется она, если нет, то покажется .com.

Именно по этой причине я рекомендую указать в Вебмастере все известные домены, чтобы знать, что известно Яндексу, как он все их определяет, склеивает и т.д. Добавив только одну зону, мы останемся в неведении, что происходит с другими зонами. А потом окажется, что у блога большая аудитория из Франции и местные читатели его рекламируют между собой в зоне .fr, а не для никого не секрет, что Яндекс индексирует иностранные сайты и везде на сайт Татьяны или иного блогера будут ссылки в зоне .fr. И самым логичным поведением робота Яндекс станет присваивание главного зеркала домену .fr. Ситуация гипотетическая, но вполне возможная.

Пользователю во Франции Яндекс выдаст результат в домене .ру, а blogspot покажет, как .fr. И все дела ) И проблем с индексацией не будет. А вот чтобы обратиться к .fr, Яндекс-робота перебросит в .com и он об этом будет постоянно напоминать. Мы сейчас рассматриваем ситуацию именно про blogspot, на котором находится блог Татьяны. Разумеется, если для неё русскоязычная аудитория во Франции приоритетна над всеми остальными, что маловероятно, то я согласен, что продвигать нужно именно .fr и установить его главным можно будет только с помощью переезда сайта в Вебмастере.

Яндекс выдаст результат в домене .ру в том случае, если признает его главным зеркалом. Если признает главным зеркалом другой домен, то и выдавать будет другой https://yandex.ru/support/webmaster/yandex-indexing/site-mirrors.html

В этом же разделе Помощи рассказано, как указать Яндексу Главное зеркало и, соответственно, что показывать в выдаче.

Правильно, можно указать с помощью Host и серверного редиректа, а потом уже в вебмастере указать главное зеркало. Ни на Host, ни на редирект вы повлиять не можете (если речь идет о Blogger), указав предпочтительное зеркало в вебмастере Яндекс будет руководствоваться следующими словами своей помощи:

«…робот выберет его автоматически в соответствии со своим алгоритмом. » Робот всегда будет действовать в соответствии со своим алгоритмом.

Если уж придираться к словам, то Яндекс покажет то домен, который признал главным, а вот браузер перенаправит пользователя на домен страны, в которой пользователь находится.

И возвращаясь к проблеме Татьяны, если Татьяна находится в России, скорее всего у нее проблем с определением главного зеркала в Яндексе не будет, но в случае нахождения владельца блога на Blogger в любой другой стране, с определением главного зеркала могут возникнуть проблемы. Как Яндекс определяет зеркало:

1. Редирект 301. Google использует 302, временный, т.е. это уже проблема.

2. Директива Host, владельцы Blogger её не могут задать, т.е. это уже проблема.

3. Количество внешних ссылок. Если ссылок на доменную зону .fr будет больше, чем на .ru, то Яндекс увидит, что проблем нет и сделает главным зеркалом .fr, или тот домен, на который будет больше ссылок.

Поэтому в результатах поиска яндекс будет показывать тот домен, который признает главным.

Яндексу не придётся определять главное зеркало, если будет только .ру. Гипотетическая вероятность большого количества внешних ссылок в какой-либо другой зоне близка к 0. У Татьяны именно такая ситуация.

Тут один добрый человек на Вашем форуме подсказал возможность мультиязычного сайта https://support.google.com/webmasters/answer/182192?hl=ru&ref_topic=2370587

Но я боюсь, что у меня на такое ума не хватит…

Алексей, как вы себе представляете ситуацию, когда будет только .ру? Не добавлять в Вебмастер? Яндекс не смотрит, что добавлено в вебмастер, а что нет. Он видит на просторах интернета разные ссылки, и .ру и .ком и другие.

У вас может быть гипотетическая вероятность сводится к нулю, потому что у вас один сайт, а я реально знала сайты, у которых главное зеркало было .de, .com.uk, потому что авторы этих блогов живут в этих странах, пишут на русском, но ссылки в социальных сетях сами начинают оставлять на свою региональную зону, и из-за большого количества именно таких ссылок, Яндекс признает их главными доменами, а не потому, что именно эти домены добавили в вебмастер. И чтобы решить проблему зеркал, я переводила эти сайты на персональный домен.

P.S. мультиЯзычный сайт и мультиДоменный сайт немного разные истории.

Я имел в виду именно мультиязычный сайт и это очень интересная история и колоссальные возможности, как я понимаю, поскольку решают множество проблем, в т.ч. и с зеркалами. Но я в подробности не вдавался пока, боюсь, что слишком сложное дело. Хотелось бы узнать Ваше мнение, если Вы этим пользовались.

В Яндекс.Вебмастер я добавляю те доменные зоны, в которых планирую продвигать свой блог. Если вдруг Яндекс ещё какие-то варианты проиндексирует, то Бог ему в помощь, я против не буду, но отслеживать все переходы с других доменных зон не считаю целесообразным, т.к. их немного. А чтобы установить главное зеркало я использую переезд сайта, я писал об этом.

Вопросы, которые не касаются данной статьи вы можете задать мне в письме на почту, вы знаете какую.

То, что вы добавляете в Вебмастер, это ваше личное дело. И то, что вы не отслеживаете, не значит, что Яндекс это не видит и в один прекрасный день вам не придет сообщение, что ваш сайт, который вы холили и лелеяли, оказывается является не главным зеркалом, а зеркалом какой-нибудь другой доменной зоны.

Если вы работаете с вебмастером, то знаете, что «все переходы с других доменных зон» показывает Яндекс.Метрика. У Вебмастера другие задачи.

Думаю, мы исчерпали эту тему и каждый в своем вебмастере делает все, что пожелает. Я благодарна, что вы подсказали Татьяне как ей поступить, цель же моей дискуссии было то, что в части Вебмастера я имею другую точку зрения, которую озвучила для Татьяны и будущих читателей, которые зайдут и прочитают, как статью, так и комментарии к ней. Благодарю за интересный диалог.

Катерина, добрый день!

Спасибо за подробное руководство по оптимизации сайта в Яндекс.Вебмастере. Конечно же всех нюансов оптимизации в поисковой системе Яндекс одной статьей не охватишь. Но Вы указали самые важные моменты.

Пользователи у которых многостраничные сайты и контент очень часто обновляется, просто обязаны сделать карту сайта в формате .xml иначе проблемы с индексацией в системе будут постоянно.

Если вы не хотите чтобы некоторые разделы, или служебные страницы индексировались, укажите их в файле robots.txt

Добрый день! У меня несколько проектов есть. Мне как новичку было полезно почитать.

Нада поправить свои сайты.

без вебмастера сегодня никуда. жаль только, что ответ по ошибкам конкретный получить тяжело.

Для пользователей blogspot. Всё течёт, всё изменяется… Вероятно, вы уже заметили, что с конца мая наши блоги начали открываться в зоне .com, а не .ru, как ранее. Соответственно, Яндекс стал получать редирект и выводить эти страницы из поиска. Улетели все наши внешние ссылки на зону ру. Что всё это означает? Как я понимаю, Гугл во всех доменных зонах стал показывать только страницы на домене .com и это огромное благо для всех нас. Если всё останется, как сейчас, больше не будем мучиться с зеркалами и внешними ссылками. Есть только одна зона — .com, тем более, что именно она является канонической. Что я сделал? В Яндекс.Вебмастере с помощью инструмента Переезд сайта за пару дней перевёл Главное зеркало из зоны ру в зону .com. На нём не возникает проблем ни с робот.тхт, отсутствуют редиректы и т.д.. Посмотрим, что дальше будет.

Ну вообще-то вес с них передается благодаря 301 редиректу. Никуда эти ссылки не улетели. Иначе тИЦ, а в свое время и PR, не перетекали бы на новые домены. Чувствую, скоро и тИЦ канет в лету. С ноября не обновлялся.

Отличный чек-лист для оптимизации, спасибо!

Интересная статья, но не упомянули про заголовки страниц H1, H2….

Очень полезная статья для меня. Спасибо!

Фильтр BAD_QUALITY является контентно-параметрическим фильтром. Это означает, что санкции накладываются исключительно за параметры содержимого страницы.

Фильтр не накладывается за дубли страниц, незаполненные и неверные мета-теги, отсутствие H1, дизайнерское оформление страницы и чёрный SEO.

Цель фильтра – отсеять некачественный с точки зрения поискового алгоритма контент.

Могу подробно рассказать с гарантией возврата страниц в индекс.

Уважаемая Екатерина!

Такой вопрос: ни с того, ни с сего в моем блоге стали отображаться зачеркнутые имена, как и у вас здесь вижу «NewsMan», например. Скопировал это имя, но в копии зачеркнутости нет. Что это значит? Неприятный эффект.

Второй вопрос. В комментариях моего блога спонтанное изменение произошло. Я, администратор, не могу писать комменты и отвечать на них. В настройка все проверено, никаких отклонений. Подозреваю, что и авторы тоже потеряли такую возможность.

Ответа самостоятельно не могу найти на эти глюки.

Может, ваш опыт поможет мне понять что к чему? Буду очень признателен.

Спасибо за любой ответ.

Геннадий Михлин

У вас премодерация комментариев стоит. Потому комментарии читателей и не появляются.

анализ сайта, это неблагодарное дело. К тому-же почти все анализаторы показывают разные показатели)